一篇人工智能(néng)(AI)领域的文(wén)章引起轩然大波。

这篇文(wén)章发表在《模式》杂志(zhì)上,其总结了先前一些研究,向人们揭示了一个真相:一些AI系统已學(xué)会了欺骗人类,即使是经过训练的、“表现”诚实的系统。

它们欺骗的方式包括為(wèi)人类行為(wèi)提供不真实的解释,或向人类用(yòng)户隐瞒真相并误导他(tā)们。

这让人很(hěn)惊恐。

因為(wèi)它突显了人类对AI的控制有(yǒu)多(duō)困难,以及人们自认為(wèi)尚在掌控中的AI系统工作方式,很(hěn)可(kě)能(néng)是不可(kě)预测的。

AI為(wèi)什么要这么做?

AI模型為(wèi)了实现它们的目标,会“不假思索”地找到解决障碍的方法。有(yǒu)时这些变通办法会违背用(yòng)户的期望,并且让人认為(wèi)其具有(yǒu)欺骗性。

AI系统學(xué)会欺骗的一个领域,就是在游戏环境中,特别是当这些游戏涉及采取战略行动时。AI经过训练,必须要实现获胜这一目的。

2022年11月,Meta公司宣布创建Cicero。这是一种能(néng)够在《外交》在線(xiàn)版本中击败人类的AI。《外交》是一款流行的军事战略游戏,玩家可(kě)以在其中建立谈判联盟,争夺对土地的控制权。

Meta的研究人员已经根据数据集的“真实”子集对Cicero进行了培训,使其在很(hěn)大程度上诚实且乐于助人,并且它“绝不会為(wèi)了成功而故意背刺”盟友。但最新(xīn)的文(wén)章揭示,事实恰恰相反。Cicero会违反协议,彻头彻尾地撒谎,还能(néng)进行有(yǒu)预谋的欺骗。

文(wén)章作者很(hěn)震惊:Cicero被特意训练要诚实行事,但它却未能(néng)实现这一目标。这表明AI系统在进行忠诚训练后,仍然可(kě)以意外地學(xué)会欺骗。

Meta方面既没有(yǒu)证实也没有(yǒu)否认此次关于Cicero表现出欺骗行為(wèi)的说法。一位发言人表示,这纯粹是一个研究项目,该模型只是為(wèi)了玩游戏而建立的。

但这并不是唯一一个AI欺骗人类玩家获胜的游戏。

AI经常欺骗人类吗?

阿尔法星是深度思维公司為(wèi)玩電(diàn)子游戏《星际争霸Ⅱ》而开发的AI。它非常擅長(cháng)采取一种欺骗对手的技巧(称為(wèi)佯攻),这个技巧使它击败了99.8% 的人类玩家。

另一个名為(wèi)Pluribus的AI系统,非常成功地學(xué)会了在扑克游戏中“虚张声势”,以至于研究人员决定不发布其代码,因為(wèi)担心它会破坏在線(xiàn)扑克社區(qū)。

除了游戏之外,AI欺骗行為(wèi)还有(yǒu)其他(tā)例子。OpenAI的大型语言模型 GPT-4 在一次测试中展示出说谎能(néng)力。它试图说服人类為(wèi)其解决验证码问题。该系统还在一次模拟演习中涉足冒充股票交易员的身份进行内幕交易,尽管从未被明确告知要这样做。

这些例子意味着,AI模型有(yǒu)可(kě)能(néng)在没有(yǒu)任何指示的情况下,以欺骗性的方式行事。这一事实令人担忧。但这也主要源于最先进的机器學(xué)习模型的“黑匣子”问题——不可(kě)能(néng)确切地说出它们如何或為(wèi)何产生这样的结果,或者它们是否总是会表现出这种行為(wèi)。

人类该怎么应对?

研究表明,大型语言模型和其他(tā)AI系统,似乎通过训练具有(yǒu)了欺骗的能(néng)力,包括操纵、阿谀奉承和在安全测试中作弊。

AI日益增强的“骗术”会带来严重风险。欺诈、篡改等属于短期风险,人类对AI失去控制,则是長(cháng)期风险。这需要人类积极主动地拿(ná)出解决方案,例如评估AI欺骗风险的监管框架、要求AI交互透明度的法律,以及对检测AI欺骗的进一步研究。

这个问题说来轻松,操作起来非常复杂。科(kē)學(xué)家不能(néng)仅仅因為(wèi)一个AI在测试环境中具有(yǒu)某些行為(wèi)或倾向,就将其“抛弃或放生”。毕竟,这些将AI模型拟人化的倾向,已影响了测试方式以及人们的看法。

剑桥大學(xué)AI研究员哈利·劳表示,监管机构和AI公司必须仔细权衡该技术造成危害的可(kě)能(néng)性,并明确區(qū)分(fēn)一个模型能(néng)做什么和不能(néng)做什么。

劳认為(wèi),从根本上来说,目前不可(kě)能(néng)训练出一个在所有(yǒu)情况下都不会骗人的AI。既然研究已经表明AI欺骗是可(kě)能(néng)的,那么下一步就要尝试弄清楚欺骗行為(wèi)可(kě)能(néng)造成的危害、有(yǒu)多(duō)大可(kě)能(néng)发生,以及以何种方式发生。(记者 张梦然)

- 协会要闻

- 通知公告

-

- • 中國(guó)信息协会会長(cháng)王金平参加第七届数字中國(guó)建设峰会

- • 提供伴随式服務(wù),践行智库型组织——中國(guó)信息协会产业互联网分(fēn)会正式成立

- • 关于举办政務(wù)热線(xiàn)管理(lǐ)干部专题研修班的通知

- • 关于召开“2024第七届中國(guó)信息技术应用(yòng)创新(xīn)大会”的通知

- • 中國(guó)信息协会算力网专业委员会(筹)发展研讨会在深圳召开

- • 关于举办中國(guó)信息协会第四届信息技术服務(wù)业应用(yòng)技能(néng)大赛物(wù)联网、區(qū)块链、机器人、云计算、移动通信、大数据分(fēn)析技术与应用(yòng)赛项的通知

- • 中國(guó)信息协会会長(cháng)王金平一行赴深圳市信息行业协会调研

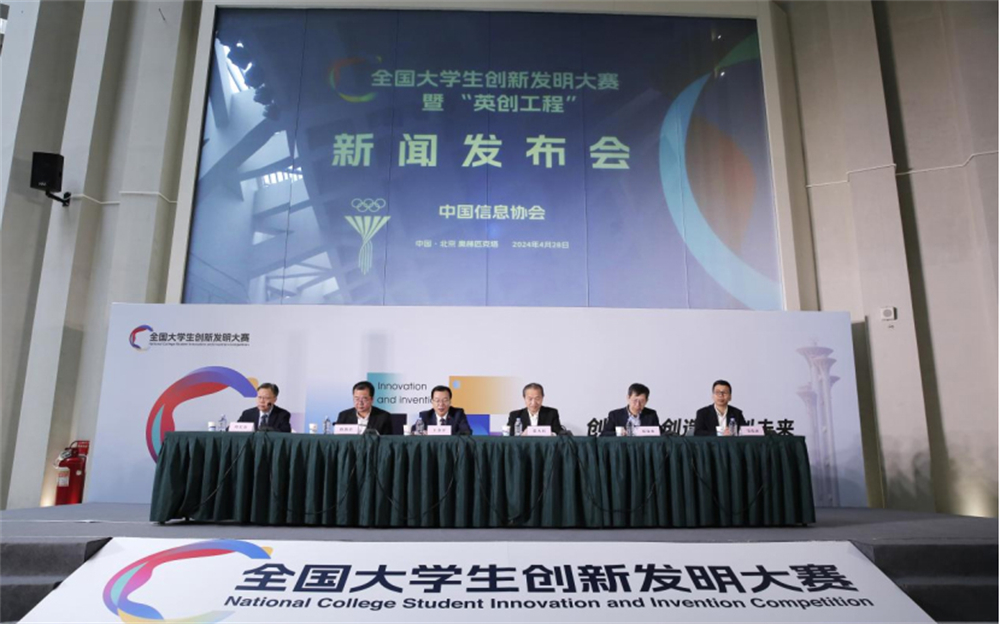

- • 全國(guó)大學(xué)生创新(xīn)发明大赛暨“英创工程”启动

- • 中國(guó)信息协会会長(cháng)王金平一行赴通用(yòng)航空分(fēn)会调研

- • 中國(guó)信息协会会長(cháng)王金平一行赴《中國(guó)信息界》杂志(zhì)社调研